Unser Forschungsprojekt SOFIE, das wir in Zusammenarbeit mit der Technischen Universität Berlin betreiben, läuft jetzt bald acht Monate. Wir haben uns gedacht, dass es mal an der Zeit ist ein kleines Update zu veröffentlichen. In diesem Blogartikel sprechen wir mit den Entwicklern, zeigen was wir schon geschafft haben und wo es am Ende hingehen soll.

Bewertungen für Produkte und Unternehmen sind nach wie vor eines der wichtigsten Instrumente für den eCommerce. Sie helfen dabei Vertrauen zwischen Kunden und Händler bzw. Dienstleister zu etablieren und die Spreu vom Weizen zu trennen. Gerade im Internet ist Vertraunswürdigkeit von elementarer Wichtigkeit, da Transaktionen ohne direkten Kontakt der beiden Parteien stattfinden. Deshalb muss die Integrität von Bewertungen im Internet geschützt werden, damit sie weiterhin einen verlässllichen Faktor darstellen.

Gerade Fakebewertungen untergraben dies, weshalb wir bei Trustami neben unserer Tätigkeit als Bewertungsdienstleister auch erhebliche Ressourcen in das bekämpfen von betrügerischen Methoden investieren. Eine unserer Maßnahmen ist das Forschugnsprojekt SOFIE, welches wir zusammen mit der Technischen Universität Berlin (TU) betreiben. Mit SOFIE soll erprobt werden, ob es möglich ist, eine zuverlässige Methode zu entwickeln, mithilfe von Künstlicher Intelligenz Fakes automatisch ausfindig und für den Verbraucher erkennbar zu machen.

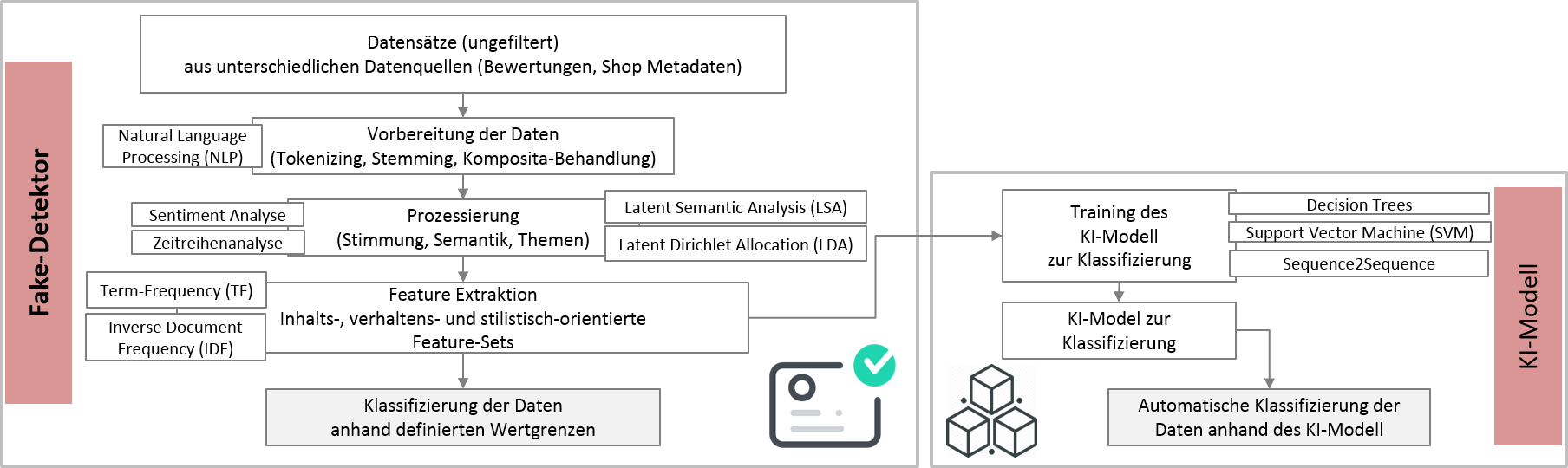

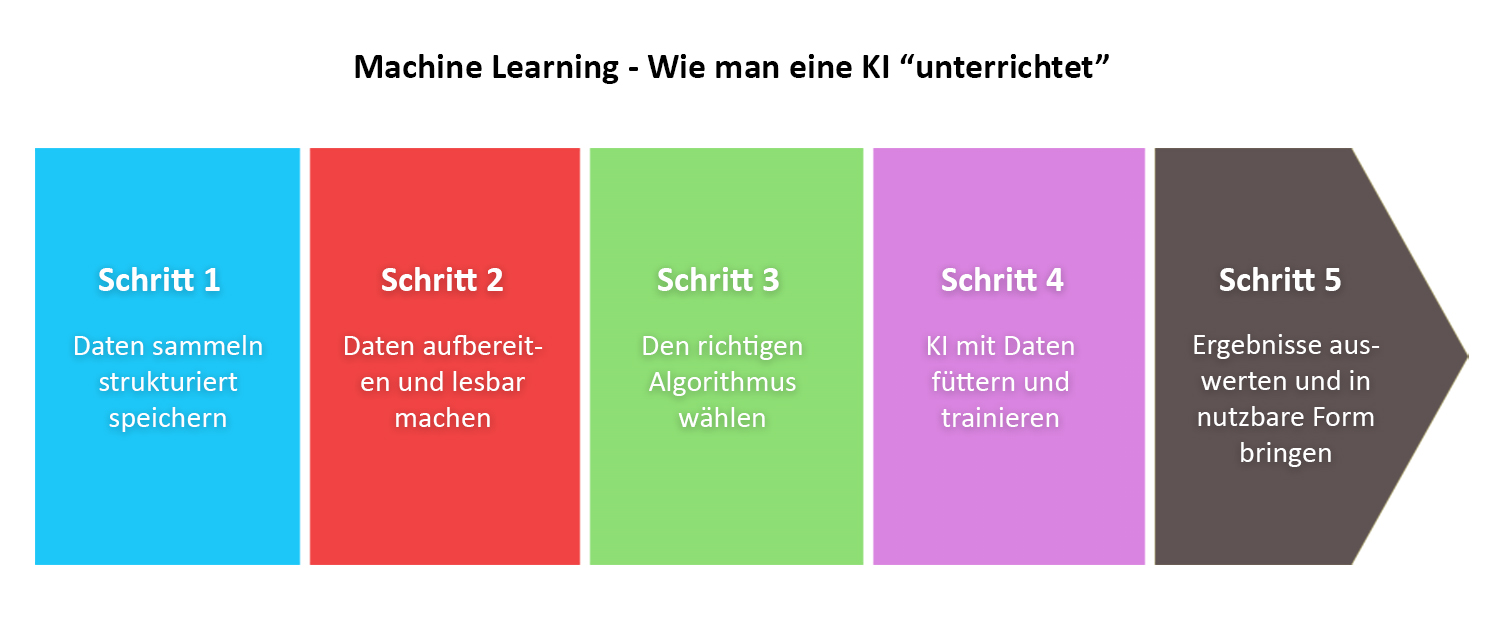

Das Projekt umfasst zwei Jahre und im Augenblick befinden wir uns noch in der Analyse und Planung. Trotzdem möchten wir gerne schon mal einen Einblick in unsere Arbeitsweise geben und erste Ergebnisse präsentieren. Ziel ist es eine selbstlernende, künstliche Intelligenz zu entwickeln, die eigenständig Bewertungen mit einem großen Datensatz an falschen Bewertungen vergleicht um Ähnlichkeiten festzustellen. Der erste Schritt ist also diesen Datensatz anzulegen und für den Algorithmus nutzbar zu machen. Denn bevor die KI selbstständig lernen kann, muss man ihr zuerst beibringen, wie sie die Daten zu lesen hat und wie sie dann weiter ausgewertet werden können.

In der ersten Phase wurde zunächst das Trustami-Team um einen neuen Experten erweitert, damit wir dem beträchtlichen Umfang des Projekts vollends gerecht werden können. Zwar sind wir in dem Gebiet bereits gut aufgestellt, jedoch übersteigt der Arbeitsaufwand, der zusätzlich zu unserer regulären Tätigkeit ausgeführt werden muss, unsere herkömmlichen Kapazitäten. Wir freuen uns auf jeden Fall sehr unseren neuen Entwickler Jona Heidsick in der Trustami-Zentrale willkommen heißen zu dürfen.

Um die KI mit Daten füttern zu können, müssen diese erstmal gesammelt werden. Benötigt werden dabei einerseits Daten, die denen gleichen, die wir am Ende erkennen möchten, also in unserem Fall Fakes. Andererseits brauchen wir natürlich echte Bewertungen, um Unterschiede feststellen zu können. Hier haben wir immerhin einen großen Vorsprung, denn das Erfassen von Bewertungsdaten ist unser täglich Brot bei Trustami. Allerdings reicht es nicht, diese Daten einfach irgendwo auf einem Server zu speichern und die KI darin spielen zu lassen wie in einem Sandkasten. Damit die Künstliche Intelligenz versteht, wie sie mit den Daten umgehen kann, müssen wir ihr genau erklären, was welche Datenteile genau bedeuten, wie sie gelesen werden müssen und welchen Schluss sie aus bestimmten Zusammenhängen ziehen kann.

Außerdem hat das Erfassen und Speichern von Daten auch immer eine rechtliche Komponente. Wir legen sehr großen Wert auf Datenschutz und Datensicherheit, weshalb wir uns im Vorfeld ausgiebig mit Datenschutzexperten auseinandergesetzt haben, um einen verantwortlichen Umgang damit gewährleisten zu können.

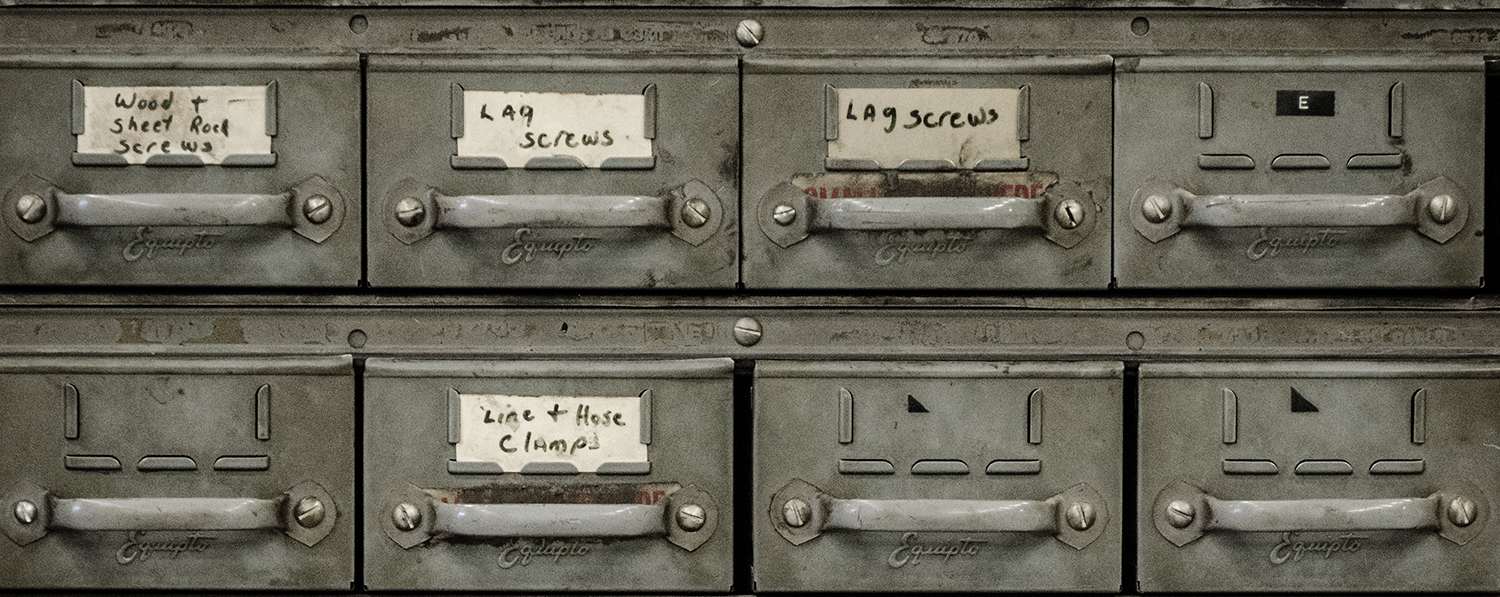

Bevor wir die Aufgabe also an die KI weitergeben können, müssen wir einige Vorarbeit leisten. Um zum Beispiel Datensätze sinnvoll zu speichern und in eine Form zu bringen, wie sie zuerst für uns und später durch die KI effizient abgerufen werden kann, benötigt es ein Speicherkonzept. Man kann sich das so vorstellen, dass wir unseren Werkzeugkasten so sortieren und beschriften, dass wir für die kommenden Aufgaben immer ganz genau wissen, wo was ist und wie wir es benutzen können.

Für die Erfassung der Daten müssen außerdem Merkmale bestimmt werden, die von uns von Interesse sind und die später hilfreich sein könnten um echte Bewertungen von Fakes zu unterscheiden. Diese Merkmale erstrecken sich von einfachen Dingen, wie Existenzdauer des betreffenden Shops, Bewertungsmenge, Bewertungsintervalle etc. bis zu mehrschichtigeren Informationen wie zum Beispiel Wortwahl und Polarität der einzelnen Bewertungstexte. Vor allem letztere sind nur schwer zu erfassen und stellen eine echte Herausforderung für die künstliche Intelligenz dar. Das liegt aber vor allem daran, dass die KI andere Bedeutungskonzepte hat als Menschen: Sie kann zwar in sekundenschnelle numerische Daten erfassen und abgleichen, um hingegen abstrakte, veränderliche Konzepte wie menschliche Sprache zu verstehen, müssen wir ihr jede Nuance einzeln eintrichtern.

Jona ist trotz Corona aus dem holländischen Exil zurückgekehrt, um das IT-Team als Software Architekt für lernende Systeme zu verstärken. Seine langjährige Erfahrung in der Einrichtung und Programmierung von Computern wird ergänzt durch das Studium der Informatik mit Schwerpunkt Machine Learning an der Radboud Universiteit Nijmegen.

Künstliche Intelligenz ist in jedem Fall ein sehr spannendes Thema und wir bei Trustami freuen uns sehr, damit unseren Beitrag im Kampf gegen Fakes leisten zu können. Heute haben wir auch noch einen exklusiven Einblick in den Entwicklungsablauf in petto: Unser Neuzugang im Entwicklungsteam, Jona Heidsick, beantwortet uns einige Fragen zu SOFIE:

Zuallererst bringt natürlich die schiere Menge an Daten ganz eigene technische Problematiken mit sich – Stichwort Big Data. Das betrifft einerseits die Verarbeitung bzw. Analyse der Daten in Bezug auf die Fragestellung hinter SOFIE. Außerdem müssen die Daten aufbereitet werden, bevor wir überhaupt anfangen können, SOFIE-Fragen zu beantworten. Zum Beispiel sind die gesammelten Reviewtexte in allen möglichen Sprachen verfasst, die wir nicht immer kennen. Das ist ein Teilproblem das wir größtenteils schon gelöst haben.

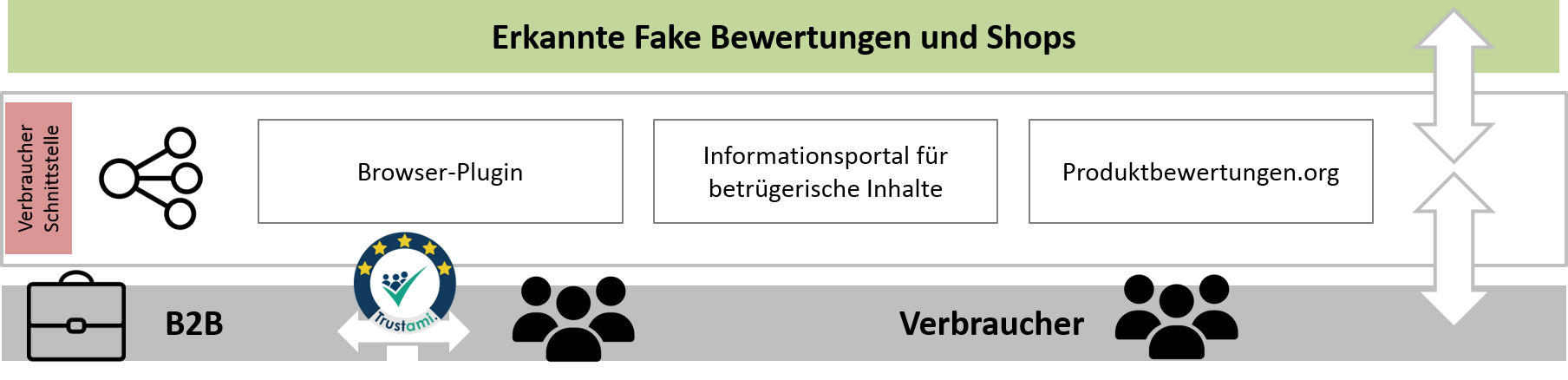

Wie könnte SOFIE irgendwann mal ganz konkret angewendet werden?

Denkbar wäre z.B. ein Browserplugin, das verdächtige Bewertungen markiert oder eine Warnung ausgibt, wenn ein Shop aufgesucht wird, der wahrscheinlich in betrügerischer Absicht handelt und keine Ware versendet. Interessanter ist es wahrscheinlich für Firmen wie Amazon, die keine gefälschten Bewertungstexte auf ihren Seiten wollen. Eventuell auch für Strafverfolgungsbehörden, um kostengünstig/automatisiert nach Betrügern im Internet zu suchen.

Entwickelt man sowas wie elterliche Gefühle, wenn man quasi eine KI von Kindesbeinen an großzieht?

Gefühle ja, elterliche nein. Natürlich ist man stolz, wenn ein System gut funktioniert. Und wenn man erstmal an dem Punkt ist, wo Algorithmus, Parameter und Daten sorgfältig ausgewählt sind und man Stunden oder Tage lang warten musste, bis das Modell trainiert war, fängt man auch an, dieses Modell zu hüten (in Form von Backups oder Speicherpunkten). An den Punkt kommt man natürlich nicht so schnell, da Entwicklung bedeutet, dass man das System beobachtet, immer wieder Dinge anpasst und Trainingsprozesse abbricht, da sie vor ihrer Fertigstellung schon wieder obsolet werden. Deshalb ist es etwas ganz Besonderes als Forscher an den Punkt zu kommen, wo man das Training seiner KI anwirft, sich zurücklehnen und beim Training zusehen darf.